工具调用的革命

大型语言模型(LLMs)虽然功能强大,但它们缺乏获取实时数据、执行精确计算、访问私有信息或执行系统操作的能力。工具调用技术正是为解决这些限制而生,它让AI能够"走出思维的牢笼",与外部世界交互。

工具调用的核心价值在于:

突破知识时效性限制

通过调用外部API,模型可以获取训练数据之外的最新信息,如当前天气、股市数据等。

增强精确计算能力

语言模型的数学能力有限,而通过调用计算工具,可以执行精确的数值计算和复杂算法。

扩展执行能力

使模型能够触发实际行动,如发送电子邮件、执行数据库查询或控制智能设备等。

Function Calling:开放API的智能桥梁

Function Calling是OpenAI于2023年推出的一项重要功能,它允许语言模型根据用户的指令决定是否需要调用特定函数,并以结构化形式生成函数参数。

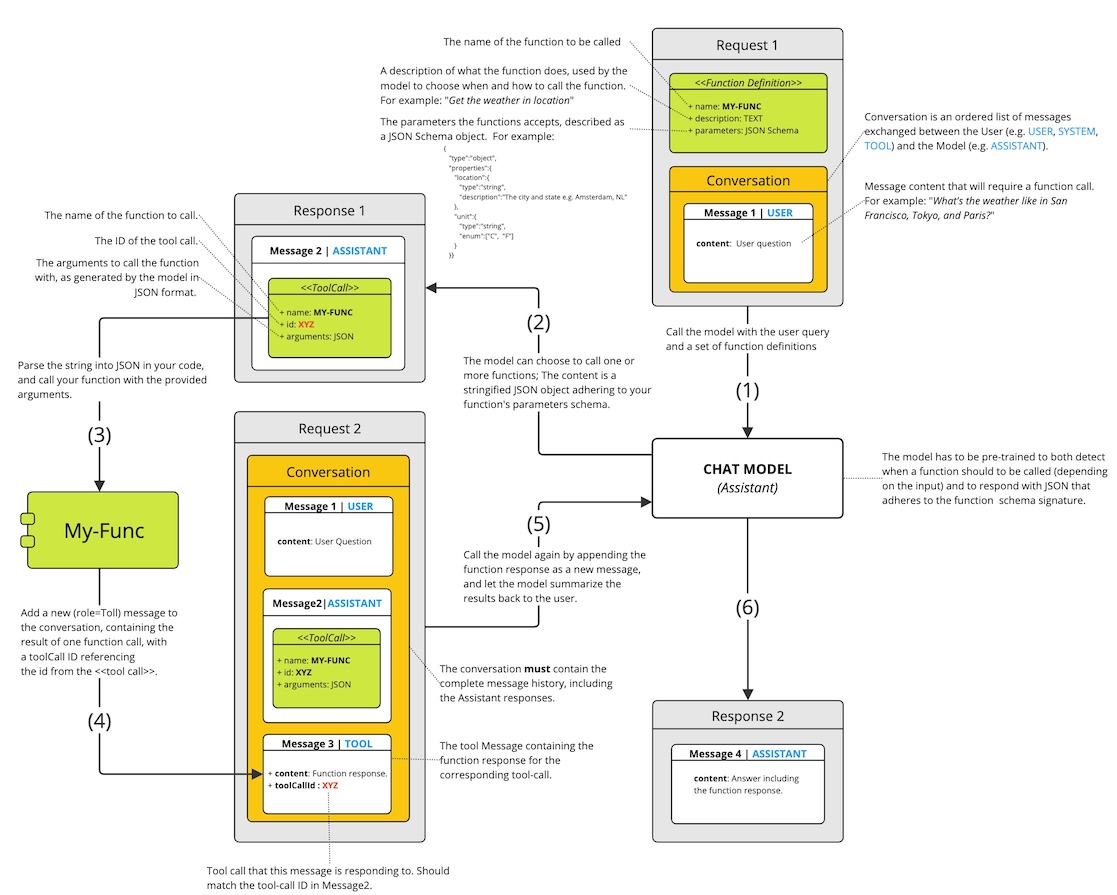

工作原理

步骤1:定义函数

开发者使用JSON Schema格式定义函数名称、描述和参数结构

步骤2:用户提问

用户提出自然语言请求

步骤3:模型决策

模型分析请求并决定是直接回答,还是调用函数

步骤4:生成参数

如需调用函数,模型生成符合Schema的结构化参数

步骤5:执行函数

应用程序执行函数并获取结果

步骤6:最终回答

结果返回给模型,模型生成整合了函数结果的最终回答

实现示例

import openai

from openai import OpenAI

client = OpenAI()

# 1. 定义函数

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "获取指定城市的天气信息",

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "城市名称"

},

"unit": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "温度单位"

}

},

"required": ["location"]

}

}

}

]

# 2. 用户提问

messages = [{"role": "user", "content": "北京今天天气怎么样?"}]

# 3. 模型决策并调用函数

response = client.chat.completions.create(

model="gpt-4-turbo",

messages=messages,

tools=tools,

tool_choice="auto"

)

response_message = response.choices[0].message

# 4. 处理函数调用

tool_calls = response_message.tool_calls

if tool_calls:

# 5. 执行函数并获取结果

weather_data = {"temperature": 25, "condition": "晴朗", "humidity": "40%"}

# 6. 将函数执行结果返回给模型

messages.append(response_message)

messages.append({

"role": "tool",

"tool_call_id": tool_calls[0].id,

"name": tool_calls[0].function.name,

"content": str(weather_data)

})

# 7. 生成最终回答

second_response = client.chat.completions.create(

model="gpt-4-turbo",

messages=messages

)

print(second_response.choices[0].message.content)

ToolFormer:自学习工具调用的先驱

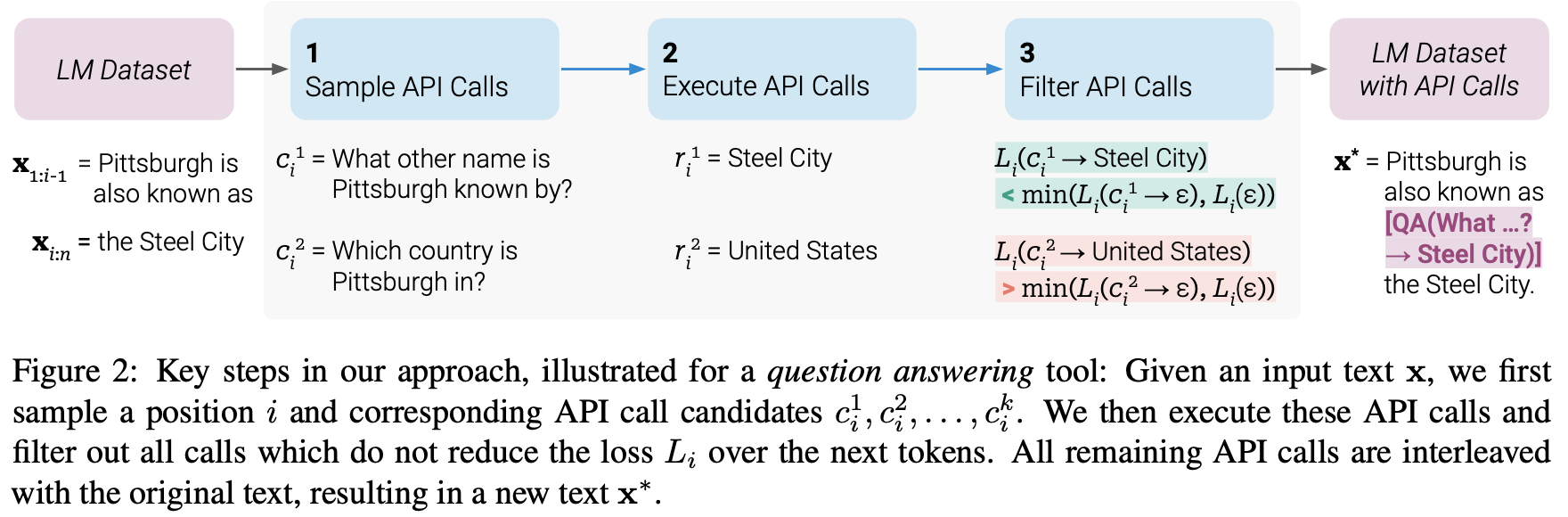

2023年2月,Meta AI发布了论文《ToolFormer: Language Models Can Teach Themselves to Use Tools》,提出了一种全新的方法——让模型自主学习如何使用外部工具,而不需要大量人工标注的数据。

ToolFormer的核心创新

自监督学习方法

ToolFormer只需少量人工示例,就能让模型自己学习何时和如何调用外部工具,大大减少了对人工标注数据的依赖。

内嵌API调用表示

使用特殊标记如<API>calculator(2+3)→5</API>直接在文本中嵌入工具调用,使模型能够学习何时生成这些标记。

有效性判断机制

通过计算与不计算API调用结果两种方式的困惑度差异,筛选出真正有助于预测的API调用,保证工具调用的质量。

通用性保持

工具调用不绑定特定任务,由模型自行决定在何种情境下调用何种工具,保持了语言模型的灵活性。

ToolFormer的工作流程

- API格式定义:使用特殊标记定义工具调用格式,如

<API>calculator(2+3)→5</API> - 候选API标注:使用大型语言模型为大规模语料库中的文本添加可能的API调用

- 有效性评估:测试API调用是否真正帮助模型更好地预测后续内容

- 筛选与训练:保留有效的API调用,并用这些数据微调语言模型

- 推理阶段调用:当模型生成API调用标记时,系统会暂停生成,执行实际API调用,并将结果插入继续生成

💡 关键见解: ToolFormer的创新之处在于它能够自动学习"何时需要使用工具",而不是将工具使用硬编码到系统中。这种方法更接近人类学习使用工具的方式,使模型在面对不同任务时能够灵活地决定是否需要借助外部工具。

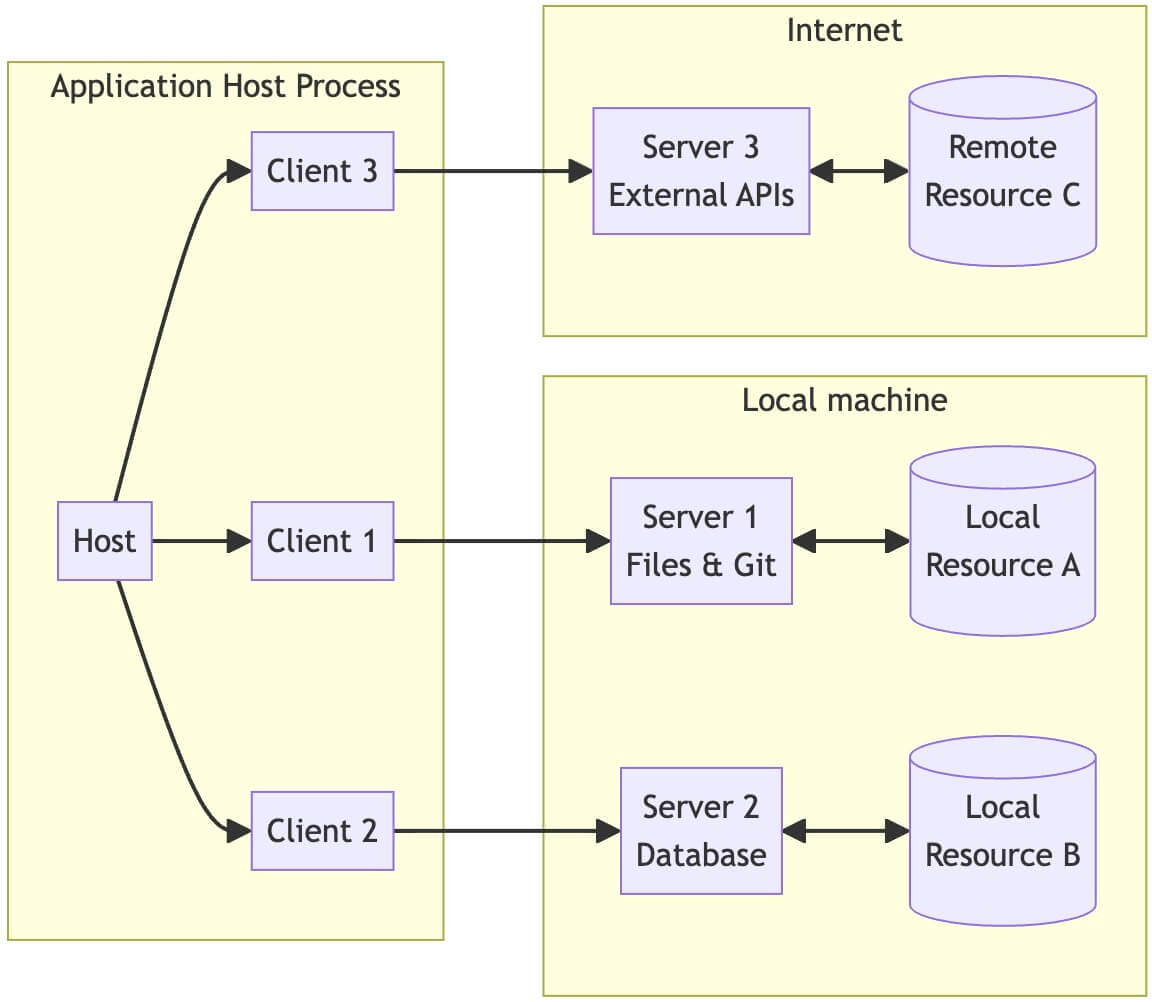

MCP:迈向统一工具调用标准

随着各大AI公司纷纷推出自己的工具调用方案,出现了需要统一标准的呼声。2024年底,Anthropic推出的Model Context Protocol (MCP)成为了一个具有潜力的开放标准,旨在统一不同平台之间的工具调用接口。

MCP的主要特点

标准化连接

类似于USB-C接口的概念,MCP为AI应用提供了标准化的连接方式,使不同的模型能够访问相同的工具和数据源。

客户端-服务器架构

采用客户端-服务器架构,AI应用作为客户端,各种工具和数据源作为服务器,通过标准协议进行通信。

安全性考量

提供健全的安全模型和权限控制,确保AI只能访问被授权的资源和工具。

多种能力支持

支持资源访问、工具调用和提示模板等多种类型的能力,使AI能够更全面地与外部世界交互。

MCP的价值主张

MCP为AI开发者和企业提供了以下核心价值:

- 减少重复工作:工具开发者只需实现一次MCP适配,即可被所有MCP兼容客户端使用

- 简化集成:AI应用开发者无需为每个工具和数据源编写自定义集成代码

- 增强安全性:标准化的权限模型和身份验证机制,减少安全漏洞

- 推动创新:降低工具开发门槛,促进更多创新工具的出现

- 提升用户体验:使AI系统能够更无缝地访问和使用各种外部能力

构建统一的工具调用框架

基于我们对Function Calling、ToolFormer和MCP的理解,我们可以构建一个统一的工具调用框架,实现跨平台、高效率的工具调用系统。

统一工具定义标准

const toolSchema = {

// 基础信息

name: "工具名称",

description: "详细描述",

version: "1.0.0",

// 参数定义(兼容JSON Schema)

parameters: {

type: "object",

properties: {

// 参数定义

},

required: []

},

// 返回值定义

returns: {

type: "object",

properties: {

// 返回值结构

}

},

// 平台特定配置

platforms: {

openai: {

// OpenAI特定配置

},

anthropic: {

// Anthropic特定配置

},

gemini: {

// Google Gemini特定配置

}

},

// 执行函数(实际实现)

execute: async (params) => {

// 工具的实际执行逻辑

return result;

}

};

跨平台适配器

class ToolAdapter {

constructor(tools) {

this.tools = tools;

}

// 转换为OpenAI格式

toOpenAIFormat() {

return this.tools.map(tool => ({

type: "function",

function: {

name: tool.name,

description: tool.description,

parameters: tool.parameters,

// 其他OpenAI特定配置

}

}));

}

// 转换为Anthropic格式

toAnthropicFormat() {

// Anthropic特定的工具格式转换

}

// 转换为Google Gemini格式

toGeminiFormat() {

// Google特定的工具格式转换

}

// 执行工具调用

async executeTool(toolName, params) {

const tool = this.tools.find(t => t.name === toolName);

if (!tool) throw new Error(`Tool ${toolName} not found`);

return await tool.execute(params);

}

}

统一调用接口

class UnifiedToolCaller {

constructor(platform, platformConfig, tools) {

this.platform = platform;

this.config = platformConfig;

this.adapter = new ToolAdapter(tools);

this.client = this._initializeClient();

}

_initializeClient() {

// 根据platform初始化对应的客户端

switch(this.platform) {

case 'openai':

return new OpenAI(this.config);

case 'anthropic':

return new Anthropic(this.config);

// 其他平台

}

}

async process(userInput) {

// 1. 转换工具为平台特定格式

const platformTools = this._getPlatformTools();

// 2. 发送请求给LLM

const response = await this._sendToLLM(userInput, platformTools);

// 3. 处理工具调用

if (this._hasToolCalls(response)) {

return await this._handleToolCalls(response, userInput);

}

// 4. 返回直接回答

return this._extractResponse(response);

}

_getPlatformTools() {

switch(this.platform) {

case 'openai':

return this.adapter.toOpenAIFormat();

// 其他平台

}

}

async _sendToLLM(input, tools) {

// 平台特定的发送方法

}

_hasToolCalls(response) {

// 平台特定的工具调用检测

}

async _handleToolCalls(response, originalInput) {

// 1. 提取工具调用

const toolCalls = this._extractToolCalls(response);

// 2. 执行工具调用

const results = [];

for (const call of toolCalls) {

const result = await this.adapter.executeTool(call.name, call.params);

results.push({ call, result });

}

// 3. 将工具调用结果返回给LLM

return await this._sendToolResultsToLLM(originalInput, response, results);

}

// 其他辅助方法...

}

工具调用互动演示

天气查询工具演示

用户:

北京今天天气怎么样?

AI思考过程:

检测到天气查询请求,需要调用weather工具获取实时天气信息...

{

"name": "get_weather",

"arguments": {

"location": "北京",

"unit": "celsius"

}

}

AI回复:

今天北京天气晴朗,气温25°C,相对湿度40%,微风。是个适合户外活动的好天气!

用户:

我需要计算123456乘以789的结果

AI思考过程:

检测到计算请求,调用calculator工具...

{

"name": "calculator",

"arguments": {

"expression": "123456 * 789"

}

}

计算结果: 97406784

AI回复:

123456乘以789的结果是97,406,784。

用户:

谁发明了相对论?

AI思考过程:

检测到事实查询,调用search工具...

{

"name": "search",

"arguments": {

"query": "谁发明了相对论"

}

}

搜索结果: 爱因斯坦于1905年提出狭义相对论,1915年提出广义相对论...

AI回复:

相对论是由阿尔伯特·爱因斯坦发明的。他在1905年发表了狭义相对论,随后在1915年又发表了广义相对论。这些理论彻底改变了我们对空间、时间和引力的理解。

用户:

将"人工智能正在改变世界"翻译成英语

AI思考过程:

检测到翻译请求,调用translate工具...

{

"name": "translate",

"arguments": {

"text": "人工智能正在改变世界",

"source_language": "zh",

"target_language": "en"

}

}

翻译结果: Artificial intelligence is changing the world.

AI回复:

翻译结果:Artificial intelligence is changing the world.

工具调用最佳实践

工具设计原则

- 遵循单一职责原则,每个工具专注于一个特定功能

- 提供清晰的描述,让模型准确理解工具用途

- 使用恰当的参数类型和描述,明确参数含义

- 实现输入验证,避免错误调用

- 妥善处理错误,以用户友好方式呈现

性能优化策略

- 支持并行工具调用,提升响应速度

- 实现结果缓存,避免重复请求

- 提供渐进式响应,在长时间运行过程中给出中间反馈

- 设置合理的超时处理,避免阻塞整个流程

- 根据上下文动态调整工具集,优化模型选择

安全性考量

- 实施参数校验,防止注入攻击

- 添加权限控制,限制敏感操作

- 实现用户确认机制,特别是对于不可逆操作

- 提供审计日志,记录工具调用活动

- 定期安全审查,评估潜在风险

用户体验优化

- 保持透明度,让用户知道AI使用了哪些工具

- 提供反馈机制,允许用户纠正工具使用错误

- 优化响应时间,减少工具调用带来的延迟

- 实现优雅的退化机制,在工具不可用时提供备选方案

- 提供自定义选项,让用户决定何时使用工具

工具调用的未来展望

工具调用技术仍处于快速发展阶段,未来可能沿以下方向演进:

更细粒度的控制

未来的工具调用框架将允许开发者更精细地控制工具的调用时机、方式和权限,实现更精准的工具调用流程。

自学习工具创建

模型将能够自动识别需要创建的工具类型,甚至自动生成工具代码,进一步降低工具开发门槛。

工具市场生态

将形成类似应用商店的工具共享和分发平台,开发者可以发布和获取各种预构建的工具。

多模态工具调用

工具调用将扩展到图像、音频、视频等多模态领域,使AI能够处理和生成更丰富的内容。

去中心化工具协议

基于开放标准的跨平台工具调用协议将成为主流,促进不同AI系统之间的互操作性。

智能工具编排

AI将能够自动编排多个工具的调用序列,解决复杂任务,类似于自动化工作流程。

延伸资源

结语

工具调用技术正在迅速改变AI应用开发的范式,从封闭的"纯思考"模型转向开放的"思考+行动"框架。通过Function Calling、ToolFormer以及统一工具协议,我们可以构建更加强大、实用的AI系统,突破传统AI应用的局限。

作为AI开发者,拥抱并掌握工具调用技术,将为您打开AI应用开发的新天地。不论是企业级应用、个人助手还是垂直领域解决方案,工具调用都将成为提升AI能力的关键技术支柱。